【保姆级教程】OAK-D-Lite树莓派项目(AI+CV)

| 来源:core-electronics 编辑:OAK中国 |

| 注:B站的视频有自动翻译的字幕,可去B站看高分辨率视频教程。 |

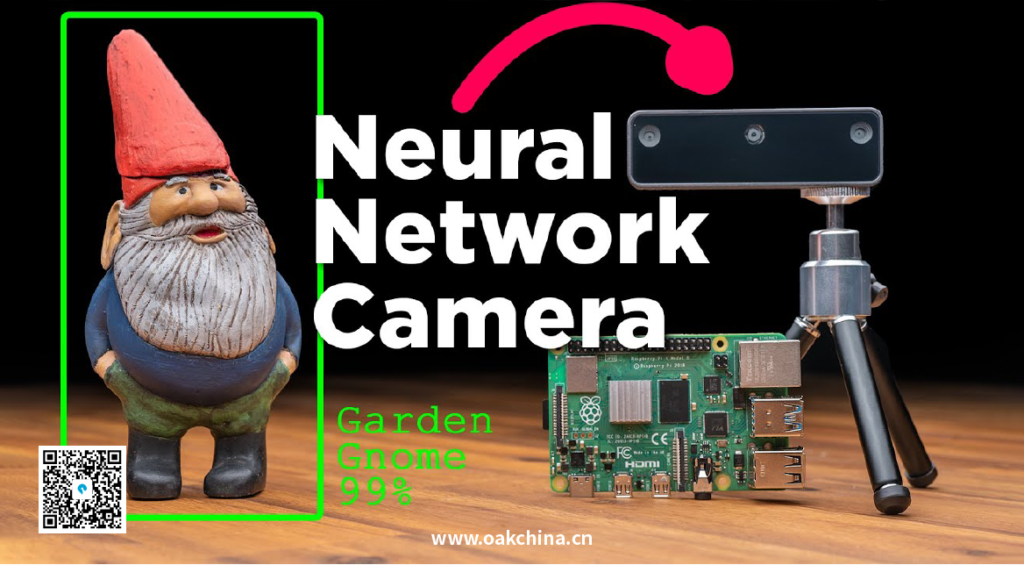

如果你在用树莓派运行机器学习的人工智能系统(如面部识别)时需要提高性能,那么我有一个解决方案给你——OAK-D-Lite相机。它相当于机器学习领域的莱泽曼军刀,在边缘处理从未如此有效。结合树莓派,你将能够探索和推动最好的和当前的深度学习系统的边界。

| 注:莱泽曼军刀是美国莱泽曼组合工具生产工厂所生产的刀具。以功能齐全闻名世界,有“组合工具的鼻祖”的美称,是进入太空的唯一组合工具。 |

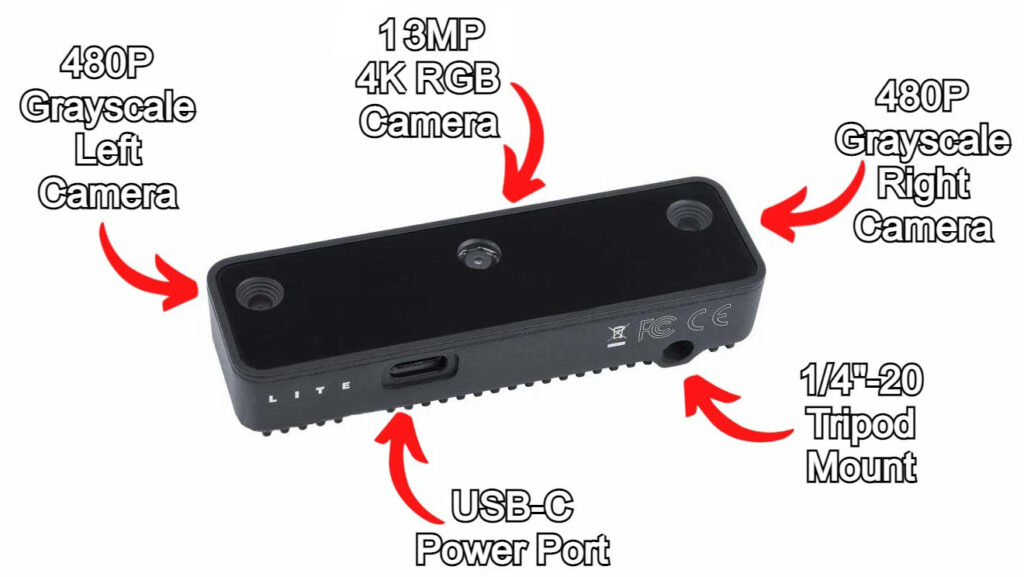

这是一个单一的USB-C供电模块,支持3个摄像头和一套电路。它就像一个谷歌Coral USB加速器,但是带有自动对焦相机。中间是高分辨率1300万像素的自动对焦RGB相机,最快能以60FPS的速度运行,还有两个480P双目立体相机,最快能以200 FPS的速度运行。OAK-D-Lite也有内部电路,可以进行机器学习处理的复杂工作,并向树莓派提供结果。因此,这就把计算操作卸载到了设备上,使你的树莓派可以自由地执行其他任务。OAK-D-Lite的大脑是一个Intel® Myriad™ X视觉处理单元(VPU)。

OAK-D是世界上第一个空间人工智能相机,OAK-D-Lite是Luxonis的新产品。两个指向前方的立体相机使OAK-D-Lite能够创建深度图,并准确地确定与识别物体的距离。这类似于人类的双眼视觉,只是更加精确。它们都可以同时运行多个神经网络,用于视觉感知任务,如物体检测、图像分类、分割、姿势估计、文本识别等,同时实时进行深度估计。这些机器学习的系统中,有不少是我之前探索过的,例如直接在树莓派4B上运行面部识别、手和手势控制以及物体检测(仅举几例)。但这些指南都没有像OAK-D-Lite那样以高帧率或高分辨率运行。这种更高的FPS速度释放了新的人工智能能力,以及在一个Python脚本中堆叠多个人工智能系统的方法,这些都是我以前的硬件无法做到的。

本教程将准确地展示这种人工智能处理如何被日常制造者所利用,同时允许他们在编程密室中一窥究竟,以查看和理解有哪些杠杆可以调整。在本指南结束时,你将拥有一台带有空间人工智能摄像头的树莓派,能够跟上边缘机器学习技术的最新进展。边缘计算是将计算和数据推到更接近它们被使用的地方,这意味着没有云计算。本教程内容如下:

- 硬件清单

- 硬件构建

- 软件设置

- GUI人工智能演示,快速概述OAK-D-Lite人工智能系统

- 双目视觉相机的测距

- Luxonis的官方示例:面部模糊和凝视估计

- 车牌追踪,挑战极限

- Cortic的项目:虚拟转置CAD模型的手势控制和远程心跳检测

- 3D打印支架

- 最后兼容的人工智能系统的大杂烩

Luxonis的OAK-D-Lite是2022年EdgeAI and Vision产品奖中相机和传感器类别的获奖产品。这款相机意味着业务,你可以在下面的图片中看到OAK-D Lite相机的注释。请记住,有两个M4大小的螺丝孔,你也可以用它来安装在背面!这里要说明的是,OAK-D-Lite也可以只作为一个处理单元,对没有直接通过摄像头获得的数据进行机器学习处理。

硬件清单

下面是你用OAK-D-Lite相机设置树莓派4B所需的一切:

- 一台树莓派掌上电脑(在我的案例中,我使用的是树莓派4B 2GB,但这个系统也非常适合早期的低规格,如树莓派3。你甚至可以使用树莓派Zero,但可能需要一些修补工作)。

- OAK-D-Lite

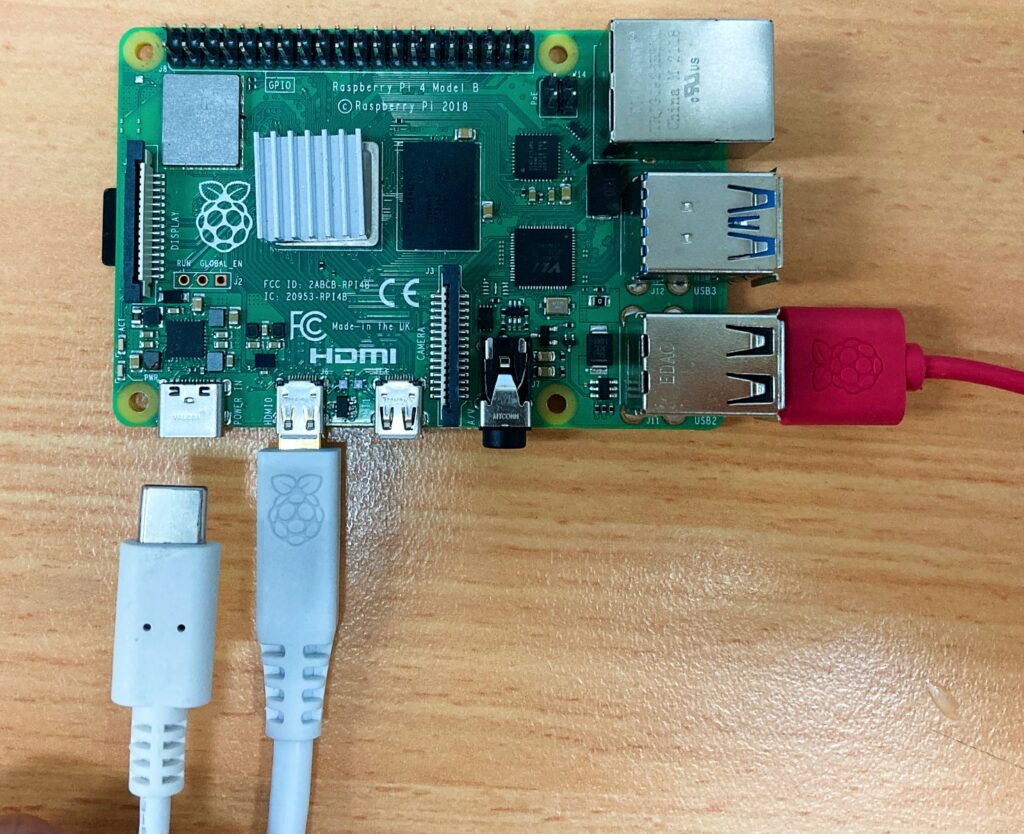

- USB3.0 Type-C线(或质量更好的),非常重要的是不要用USB2.0的线,这不会提供足够的电力/允许数据传输)。

- 三脚架

- 带有树莓派操作系统的Micro-SD卡(这里有一个关于如何做到这一点的链接)。

- 树莓派电源

- 连接到显示器的Micro-HDMI转HDMI线

- 鼠标和键盘

硬件构建

第一步自然是将所有硬件正确连接起来。为此,请完成以下步骤。首先看看下面的图片,当你手里拿着OAK-D-Lite时,你会看到什么。

在盒子里,你会发现OAK-D-Lite相机和塑料内托。该设备没有Type-C线。你可以完全像我在下面的图片中所做的那样剥掉保护层。

开箱后,移除所有包装,你现在可以开始将它连接到树莓派上。看OAK-D-Lite相机旁边的树莓派4B,它将连接到下图。它们的占地面积都差不多,但OAK-D-Lite略高,也明显更窄。

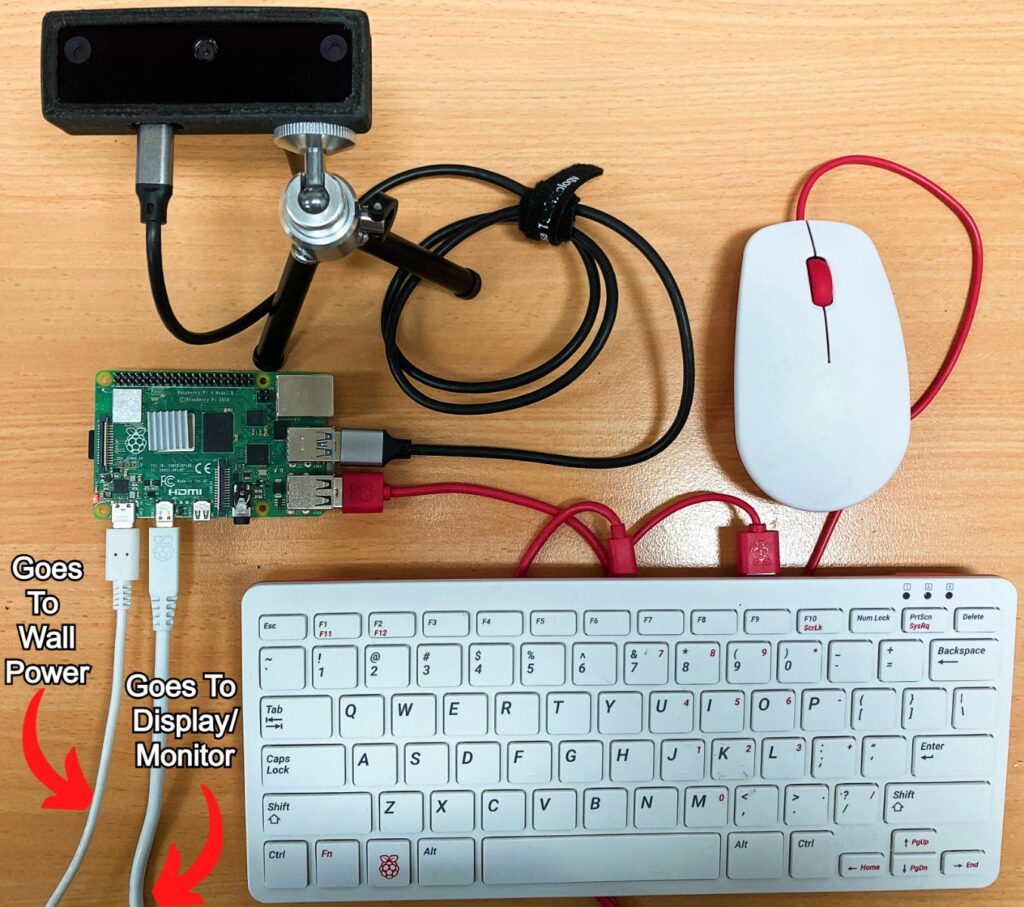

下一步是将树莓派设置为桌面计算机。暂时不要通过Type-C连接供电。如果你需要教程:用树莓派操作系统闪存一个新的MicroSD卡和如何将树莓派设置为台式电脑,请点击链接查看。下图是正确的树莓派4B设置。它有一个红色的USB2.0线连接到键盘和鼠标,HDMI线连接到监视器/显示器,Type-C线已准备好连接到系统。

接下来,将OAK-D-Lite安装到三脚架上。完成后,使用Type-C连接OAK-D-Lite和树莓派4B的USB3.0口(也就是中间蓝色的口)。这将为OAK-D-Lite及其内部电路提供电力。请注意,USB3.0设备可以在5V时提供900mA的电流,这足以满足大多数使用情况。在下图中可以看到所有的组装过程。

这里需要注意的是,可以使用OAK Y型转接头,这意味着你将能够直接为OAK-D-Lite供电。如果你在树莓派上运行高性能/计算密集型程序,你可能需要这样做。计算密集型函数的示例包括使用推理或视频编码的函数,因为这些函数在运行时会导致较大的电流尖峰。如果你将OAK-D-Lite与较早版本的树莓派 配合使用,而该树莓派没有USB3.0输出或无法从树莓派为多个设备供电,你可能也想这样做。在这些情况下,你可能需要为OAK-D-Lite使用Y型转接头。

然后,使用TypeC线给树莓派供电,完成系统启动。另外,请注意,我已经用3D打印出了OAK-D-Lite的保护壳,3D文件。完整的硬件组件见下图:

软件设置

随着硬件设置完成,是时候把注意力转向软件了。为了清楚起见,我正在使用树莓派操作系统(Bullseye)Linux版本11。每次新的树莓派操作系统首次启动时,都会弹出一个新的安装向导。它将使你能够设置你的国家、语言和时区,更改默认密码,确保屏幕设置正确,确保连接到WIFI网络,并完全更新软件。这是非常直观的,一旦完成,你的树莓派系统将自动重启。

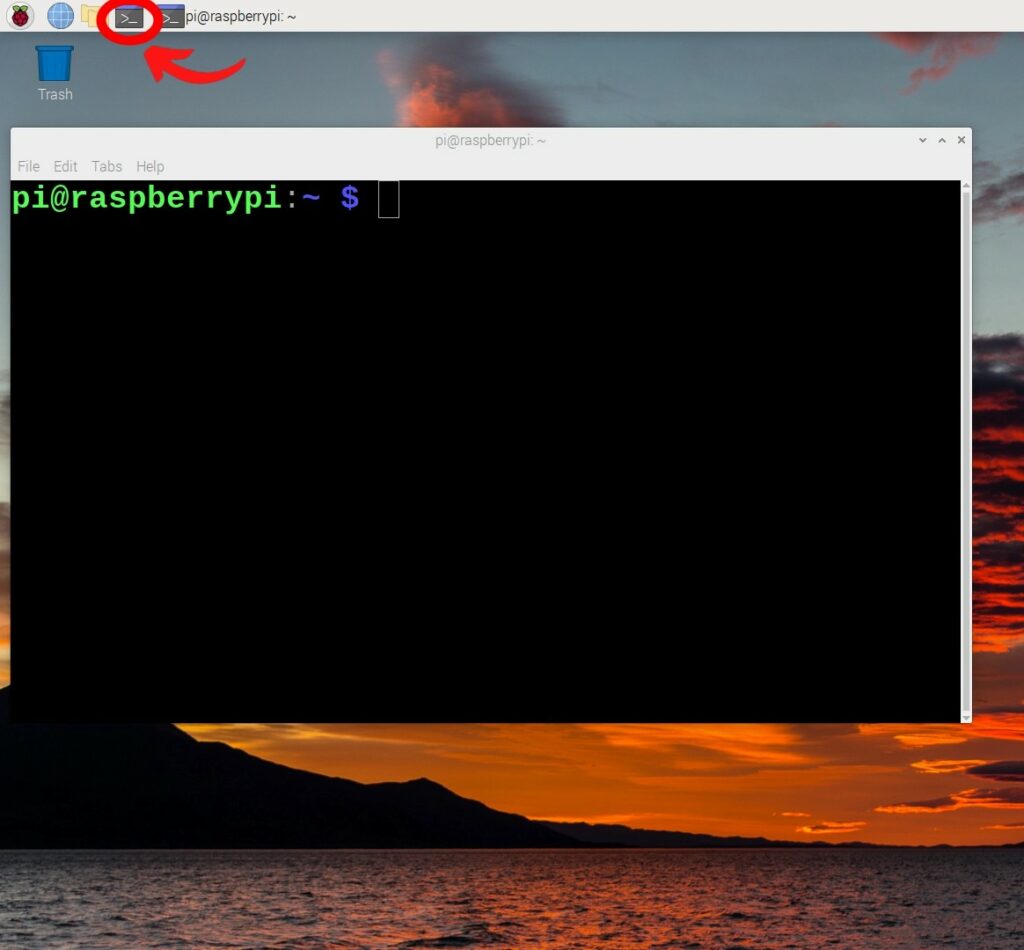

然后树莓派桌面会出现欢迎语。这是一个机器学习系统,所以我们现在需要安装软件包,使这个相机模块与树莓派一起工作,并提供Python编程语言(可以在树莓派和OAK-D-Lite上运行)运行所需的所有包。Luxonis(这款精巧设备的制造商)为我们做了大量艰苦的工作。按下屏幕左上角的黑色按钮,打开一个新的终端窗口,如下图所示。

在终端窗口中键入并输入以下终端命令(或复制并粘贴它们)。在进入下一个命令之前,让每个命令完成。如果出现提示,Do you want to continue? (y/n),按下Y然后回车,继续这个过程。整个过程应该不到25分钟。

sudo curl -fL https://docs.luxonis.com/install_dependencies.sh | bash

python3 -m pip install depthai

git clone https://github.com/luxonis/depthai-python.git

cd depthai-python

cd examples

sudo python3 install_requirements.py

cd

sudo pip3 install opencv-python

sudo pip3 install -U numpy

sudo python3 -m pip install depthai --user

cd depthai-python/examples运行以下命令来测试到目前为止的安装情况。如果弹出一个小的视频预览窗口,就可以继续安装了。成功后,在键盘上键入Ctrl+C 停止 rgb _预览运行的Python脚本。

sudo python 3 color camera/RGB _ preview . py确认成功后,通过正常键入和输入(或复制和粘贴)终端命令来继续该过程。最后两行给出了非常需要的规则,以帮助相机模块通过USB-C 3.0(或更好的)线与树莓派正确通信。

sudo git clone https://github.com/luxonis/depthai.git

cd depthai

sudo python3 install_requirements.py

cd

echo 'SUBSYSTEM=="usb", ATTRS{idVendor}=="03e7", MODE="0666"' | sudo tee /etc/udev/rules.d/80-movidius.rules

sudo udevadm control --reload-rules && sudo udevadm trigger用于Luxonis Python脚本演示的附加终端命令

sudo git clone https://github.com/luxonis/depthai-experiments.git

sudo python3 -m pip install depthai-sdk

sudo python3 -m pip install --extra-index-url https://www.piwheels.org/simple/ depthai-sdkCortic Technology Python脚本演示的附加终端命令

sudo apt-get install freeglut3-dev

sudo pip3 install pywavefront

sudo pip3 install PyOpenGL

sudo pip3 install pygame_gui -U

sudo apt install libsdl2-ttf-2.0-0

sudo pip3 install pywavefront

sudo git clone https://github.com/cortictechnology/vision_ui.git

sudo git clone https://github.com/cortictechnology/heartrate_estimation.gitGUI人工智能演示,快速概述OAK-D-Lite人工智能系统

OAK相机可以运行任何人工智能模型,甚至是自定义的模型。你甚至可以同时运行多个人工智能模型,无论是并行还是串行,这意味着我们有很多事情要做。现在,我们可以在/home/pi/depthai-python/examples 一个接一个地浏览所有的Python脚本示例。事实上,如果你像我一样好奇,那有一个更好的方法!

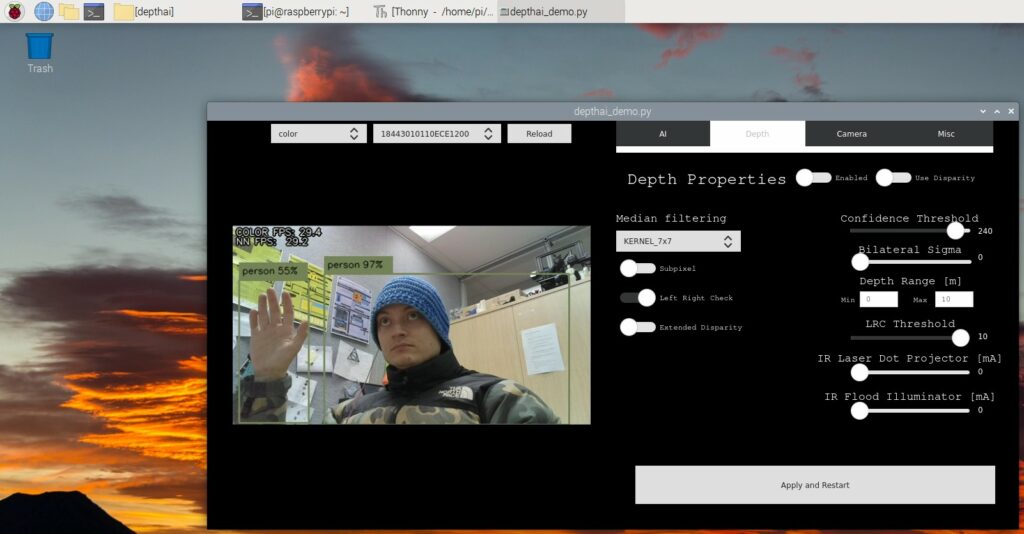

Luxonis为他们的OAK-D相机和Python示例创建了一个漂亮的图形用户界面(GUI ),现在可以打开并使用了。这将让我们在14个不同的机器学习系统之间跳转,同时不断显示一个预览窗口,可以在所有的相机之间交换。此外,它还增加了大量的相机调整功能,你可以通过切换和滑块快速调整。当利用适用的AI系统时,你还可以添加深度AI层。请看下面的图片,了解这个图形用户界面的样子。

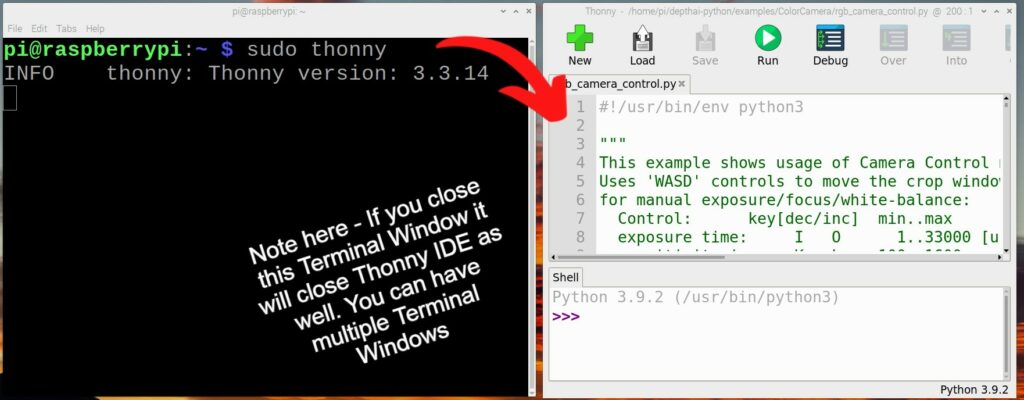

为此,我们将使用屏幕左上角的黑色按钮打开一个新的终端窗口。从这里键入并输入下面的行,打开一个具有完全权限的新Thonny IDE。

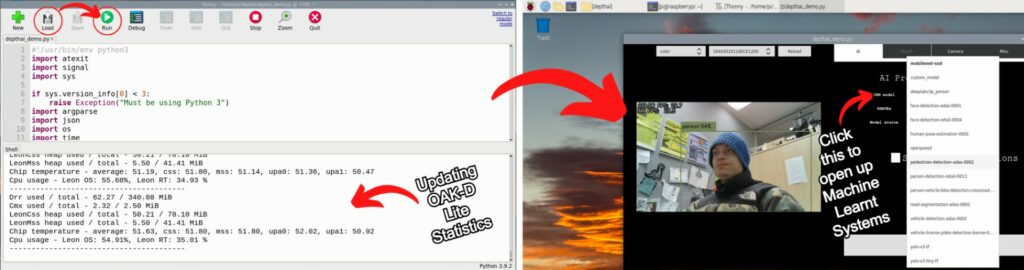

sudo thonny一旦你按下回车键,这一行将运行并打开一个新的Thonny IDE,它拥有Sudo级别的特权,你可以在下图中看到这一点。Sudo代表“substitute user do”或“super user do ”,它允许你临时提升当前的用户帐户以拥有root权限。以这种方式运行Thonny IDE将会停止任何不在默认用户路径上运行的Python脚本的问题。Thonny IDE只是一个Python编程语言解释器,你可以使用任何你想要的解释器。

现在打开它,使用Thonny IDE的顶部工具栏,按下Load按钮,这将打开一个文件浏览器。你要查找的文件位于此目录位置 /home/pi/depthai 并被命名为 depthai_demo.py 。一旦你运行它,GUI系统将会打开(或者自动开始从树莓派传送相机模块需要的任何额外的包/机器学习系统)。一旦完成,Sudo Thonny IDE将看起来很像下面的左图。右下图显示了运行机器学习Python脚本的GUI,以及当前可用的所有机器学习系统的下拉列表,我们可以轻松地在它们之间点击。

这里值得注意的是,你也可以像平常一样打开所有的Python脚本(直接从Thonny IDE),但是由于我们现在已经在系统上安装了大量的人工智能系统,使用这个GUI可以更快地获得一个概览。喝杯咖啡的功夫,你差不多就能吸收学会它了。在这里,你可以随意地浏览和测试。

对于大多数系统,在预览窗口的左上角会显示FPS。使用Yolo3 Tiny-TF的对象检测大约28+ FPS。与我在《使用树莓派的物体和动物检测教程》中所做的那样,仅在树莓派板上做所有的计算,这是一个显著的FPS改进(之前这个结果是低于10FPS)。这种增加的FPS发生在我以前探索过的所有机器学习系统上。请看下面的图片,是我使用这个GUI演示运行的机器学习系统的大杂烩(有FPS计数)。其中许多与我以前创建的人工智能系统重叠,但那些系统只使用树莓派进行计算。最右边的是利用遮罩,这比简单地在目标周围放一个盒子更需要计算。

要知道,运行这些的每一段代码都是开源的,直接在我面前的物理系统上运行。这通常被称为边缘处理。因此,如果你想学习、修改、添加或做本教程中探讨的任何脚本,你都可以!

双目视觉相机的测距

从上面我们可以清楚地看到,当运行机器学习的Python脚本时,与我以前的AI和树莓派教程 相比,FPS有了巨大的提高。弄清楚这一点后,请允许我逐章展示所有这些额外的计算能力和硬件还能实现什么。

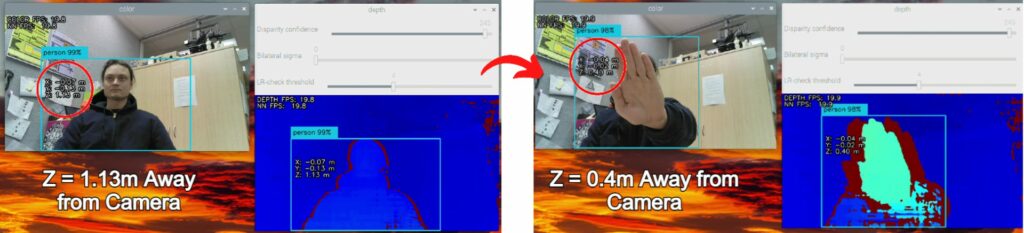

首先,让我们探讨一下硬件的物理位置所带来的优势,特别是这两个相距7.5厘米的480P摄像机。完全相同的摄像机。这与人类有很多相似之处,因为他们有两个相距10厘米左右的光传感器。人脑会自动探测距离,并赋予人类粗略判断和理解周围物体距离的能力。OAK-D-Lite相机可以做完全相同的事情,但老实说,它做得更准确。

要运行此功能,请先运行上一节中提到的 depthai_demo.py GUI界面。在AI选项卡上选择 mobilenet-ssd 。完成后,导航到 深度 标签。只需切换到 Enabled 。然后单击位于GUI的右下角的 Apply and Restart 。然后,这将打开摄像机的两个实时画面,你可以在下面的图片中看到。通常情况下,彩色窗口是中间4K摄像机,大多数蓝色窗口是两个边缘摄像机的组合。深酒红色的部分是只有一个边缘摄像机能看到的区域,而另一个则看不到。通过人工智能插值,可以从这些信息中获得目标的距离。关于目标,该系统使用机器学习系统来识别人,然后瞄准其中心。因此,我们有两个机器学习系统在树莓派系统上以19+FPS的速度顺利工作。

所有非模块化OAK设备在装运前都经过校准。如果你发现结果不准确,你可以在示例中找到一个脚本,名为 rgb-depth-alignment.py ,去做深度对齐。如果你要重新校准,请查看此教程。

Luxonis的官方示例:面部模糊和凝视估计

完成以上所有工作后,现在让我们探索一些Luxonis的示例代码。

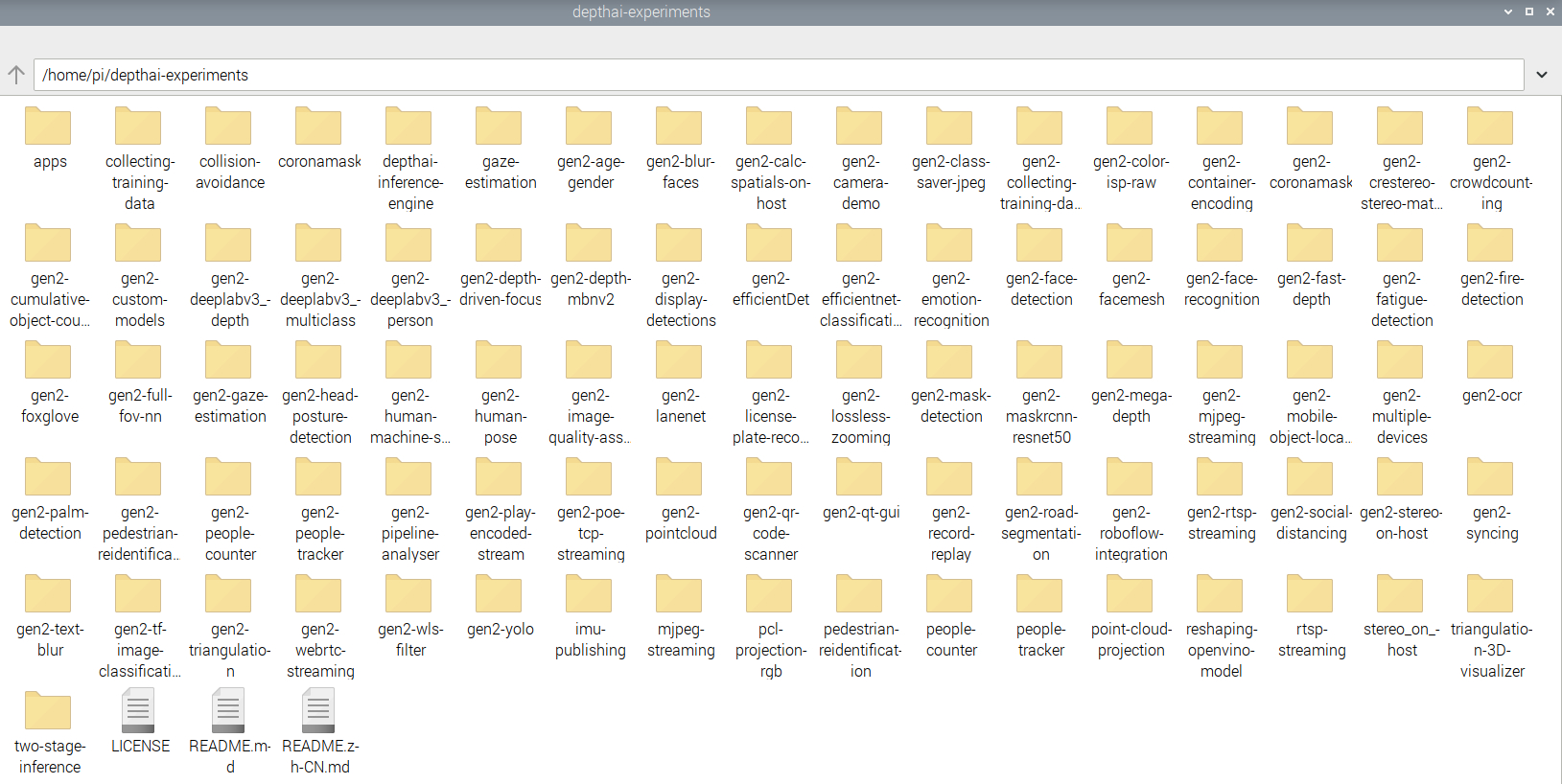

这一部分的Python脚本不一定能以30+FPS的速度运行,也不一定能在不做一些调整的情况下始终保持全功能。有些代码可能达到了GitHub高级教程的水平,有些可能只是一个框架。当这些标准被满足时,人工智能系统就会升级到主要的 depthai-python。现在你必须看到这个才能相信,下面是目录 /home/pi/depthai-experiments 的图片。每个文件夹里面都有一个独特的机器学习系统,我们可以运行。我在文章的顶部提到,这是机器学习世界的皮匠多用工具,这里就是证据。然而,莱泽曼军刀的比较对OAK-D-Lite来说并不公平,这更像是威戈Giant瑞士军刀16999。

| 注:威戈Giant瑞士军刀16999被称为史上最强悍的瑞士军刀。 |

所有这些机器学习的内容都是开源的,老实说非常惊人。文件夹的标题很好地说明了机器学习的脚本,所以花点时间看看它们。但这让我陷入了困境,我怎么能在一个单一的教程中展示这一切呢?上面的演示GUI已经涵盖了大多数以前涵盖的机器学习系统,并证明它们与OAK-D-Lite一起运行总是更好(有时是一个数量级的更好)。因此,从这里开始,我将挑出我个人最喜欢的东西。从现在开始,我们正在做2022年机器学习深度学习边缘系统的最大热门。

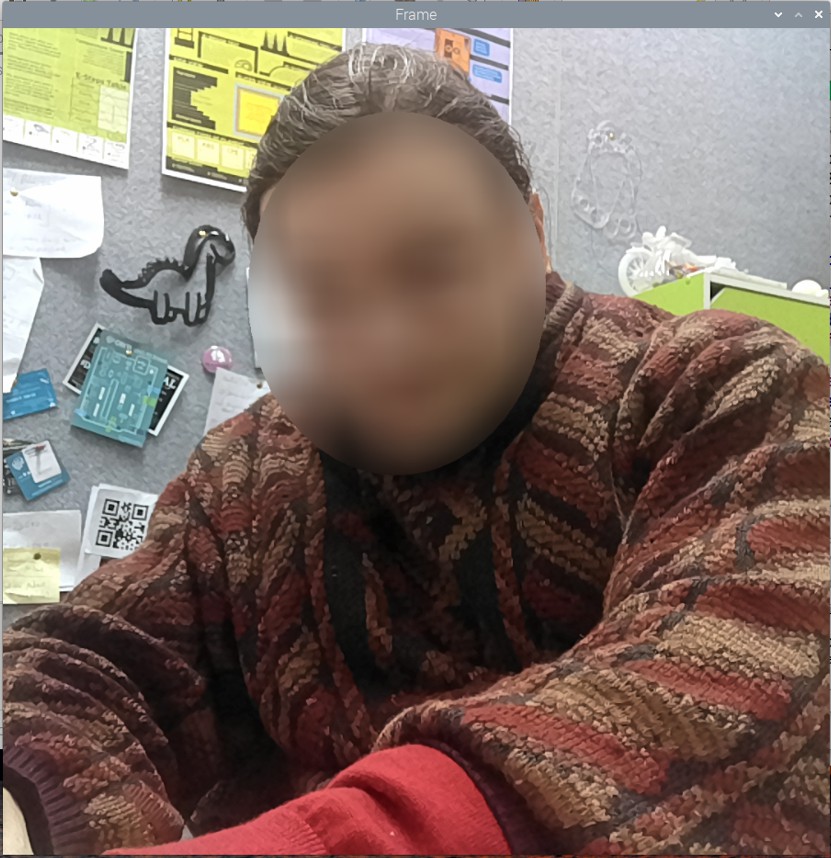

我们可以使用面部检测来实现面部模糊,这意味着我们可以不用特别看他们的脸就能计数。很好吧?

我们要打开的脚本叫做 main.py ,重要的是,你可以在 home/pi/depthai-experiments/gen2-blur-faces 目录下找到它。打开它,用Sudo Thonny IDE Instance运行它。请看下图中这个脚本运行时弹出的实时窗口(鉴于上述情况,你也许能分辨出无论模糊与否,谁是事实上的模糊背后)。这个系统可以处理多个面孔,而且运行非常顺畅。

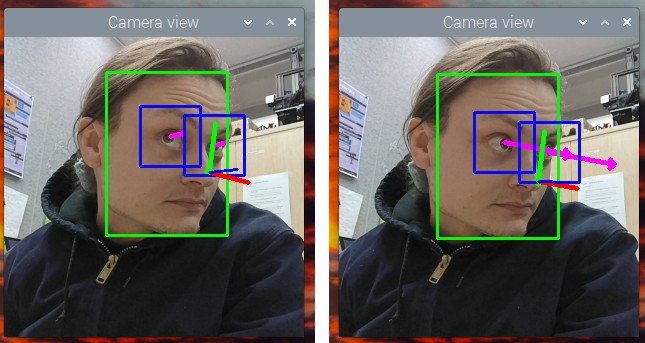

下一个我非常欣赏的脚本是在 gen2-gaze-estimation 中找到的,其python文件名为 main.py 。在Sudo Thonny IDE实例中打开并运行它,它将创建一个视频预览窗口,如下图所示。这个机器学习系统可以识别和跟踪人脸。然后,它映射出所识别的人脸的拓扑结构。然后,它将注意力集中在眼睛上,并在你的眼睛所看的方向上推断出粉色箭头。同时,它跟踪你的鼻子,并提供一个它认为你的脸所指向的XYZ轴。通过眼睛的移动和脸部的方向来控制鼠标,这无疑是一种可能性,让人想到。所有的脚本都是开源的,因此这绝对是可能的。

车牌追踪,挑战极限

由于我们现在处于Luxonis提供的实验示例,让我们探索一些真正推动我们的树莓派系统的脚本,几乎到了突破点。现在我们知道,在这一部分中,一些编程脚本不一定能以30+FPS的速度运行,也不一定能完全发挥作用。当这些标准得到满足时,它们将被升级为标准的Luxonis产品。推进系统的Python脚本通常利用多层机器学习的过程堆叠在一起。

这里面是AI机器学习系统,它推动了Luxonis OAK-D相机的极限。而我最喜欢的是车牌+汽车识别。这将记录所有它看到的汽车,对它们进行分类(颜色和类型),并记录它们。它还会锁定车牌,对文字/数字进行解码,并将其记录下来。请看下面图片中发生的(已经下载的)视频例子。

现在,所有以前的机器学习系统的例子都能在我们已经安装的软件包中完美运行。然而,这些实验性脚本中的一些需要额外的步骤才能完美运行。如果我们试图像以前那样运行它们,它们会向shell发送一长串红色的错误信息。这不是我们想要的,所以为了解决这个问题,我们做了以下工作。几乎所有这些文件夹里都有名为 requirements.txt 的文本文件。如果我们把控制台终端对准所需机器学习系统的目录,我们就可以键入并输入以下内容。

sudo python3 -m pip install -r requirements.txt这样做意味着我们的树莓派系统将在互联网上搜索所有我们可能需要的特定机器学习系统的额外Python包。我将对车牌机器学习系统进行这一工作流程,因为该Python脚本需要它来正确运行。因此,打开一个新的终端控制台,我们将逐一键入并输入以下内容。

cd /home/pi/depthai-experiments/gen2-license-plate-recognition

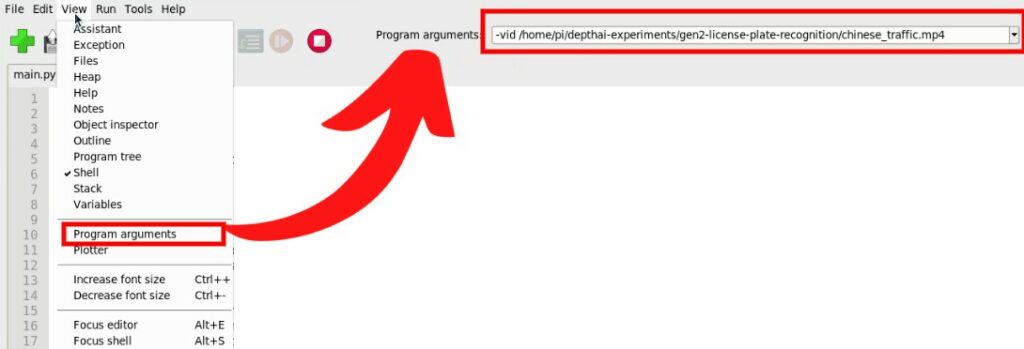

sudo python3 -m pip install -r requirements.txt这将需要一点时间来完成,但一旦完成,你就可以了。打开Sudo Thonny IDE,按照之前的方法打开 main.py python脚本。重要的是,你可以在 home/pi/depthai-experiments/gen2-license-plate-recognition 目录下找到它。我们需要在Python脚本中添加一个Pointer/Argument,这样它才能正确运行。要在Thonny IDE中添加Argument功能,请确保其在常规模式下运行。然后使用顶部的工具栏点击 View 并向下悬停,点击 Program arguments 。然后在Thonny IDE的右上方提供一个部分,你可以在那里添加参数。参数是独立的项目,或称变量,包含数据或代码。当一个参数被用来为用户定制程序时,它通常被称为参数。因此,我们将通过输入 -vid /home/pi/depthai-experiments/gen2-license-plate-recognition/chinese_traffic.mp4 来添加参数,如你在下面的图片中可以看到。你也可以添加参数 -cam 来获得一个实时反馈预览窗口。

完成后,按下脚本上的绿色运行按钮。几秒钟后,预览窗口将弹出,默认将从视频中抓取汽车和车牌细节。这个edge系统正在推动我们的硬件,对于这个高清视频,它以大约7FPS的速度运行。也许通过一些脚本/机器学习的调整,我们将拥有一个可以全速运行(30FPS)的系统,但我还没有做到这一点。你可以使用参数选项将此脚本指向任何视频。此外,请注意,车牌检测系统是针对中国车牌进行训练的,因此结果可能会因你所在的国家或地区而异。

Cortic的项目:虚拟转置CAD模型的手势控制和远程心跳检测

这个相机太火了,这就是为什么许多组织和开源企业家都加入了这一行列。

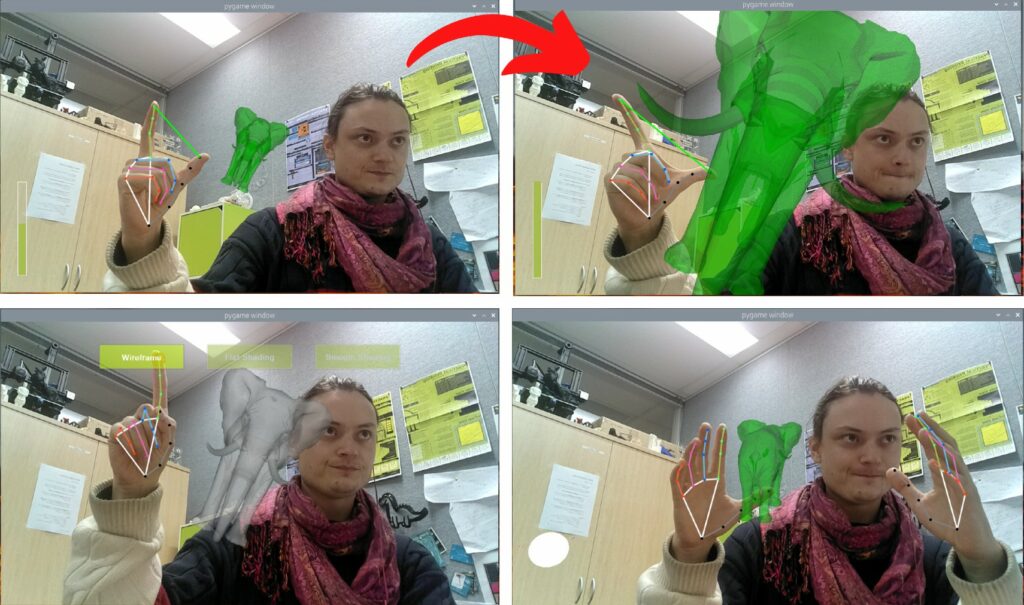

这些无畏的组织之一就有总部位于加拿大的科尔蒂科技公司,他们创建了一个机器学习系统,该系统接受手势控制,并允许你操纵投影到你面前的人工现实中的STL/CAD模型。打开一个Sudo Thonny IDE并打开 main.py, python脚本的方式和以前一样。重要的是,你可以在目录下找到它 home/pi/vision_ui/ 。像往常一样按下绿色的运行按钮来运行它。

用文字来描述有点复杂,但用图片(和视频)就清楚多了。所以检查下面的图片来了解正在发生的事情(你也可以欣赏我专注的表情)。

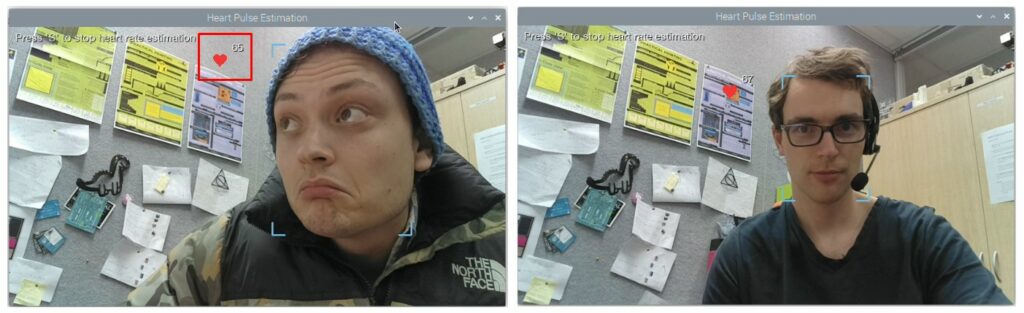

我们还要用摄像头远程监控自己的心跳!这意味着我们不再需要佩戴苹果手表或在皮肤上贴上电线/传感器来了解这些信息。我们可以在摄像机的视野下,看到我们的心跳随之波动。

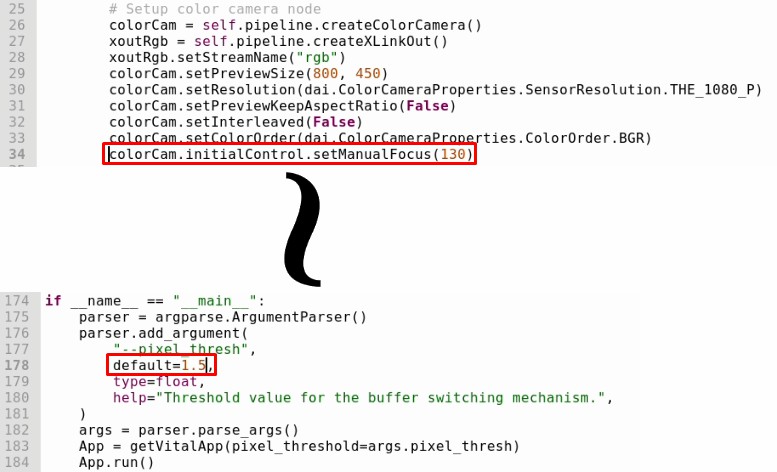

打开一个Sudo Thonny IDE并打开 main.py ,python脚本的方式和以前一样。重要的是,你可以在home/pi/heart rate _ estimation-main/heart rate _ estimation-main/ 目录下找到它。我们将需要改变设置中的两条线。注释掉行 colorcam . initial control . setmanualfocus(130) 通过键入 # 在这行代码前面。因此,修改后的行看起来像这样 # colorcam . initial control . setmanualfocus(130) 。还要明白,我们最有力的杠杆是像素阈值。使用介于1.5和 2 之间的值,这将有助于我们获得更准确的结果,并适应不同照明的环境。

然后按下绿色的运行按钮,像平常一样运行这些程序。将会打开一个视频预览窗口,如下所示。它会开始追踪人脸。在键盘上敲 S 选择预览窗口,将开始心率估计。查看下图,了解系统运行情况。你也会注意到我最初看数据时的怀疑表情。我们现象级核心电子产品支持团队的巨星Trent恰好戴着一块苹果手表。所以我带他过来做了一个快速测试,以确认结果在正确的范围内,确实如此!精确到大约±5 BPM的范围。

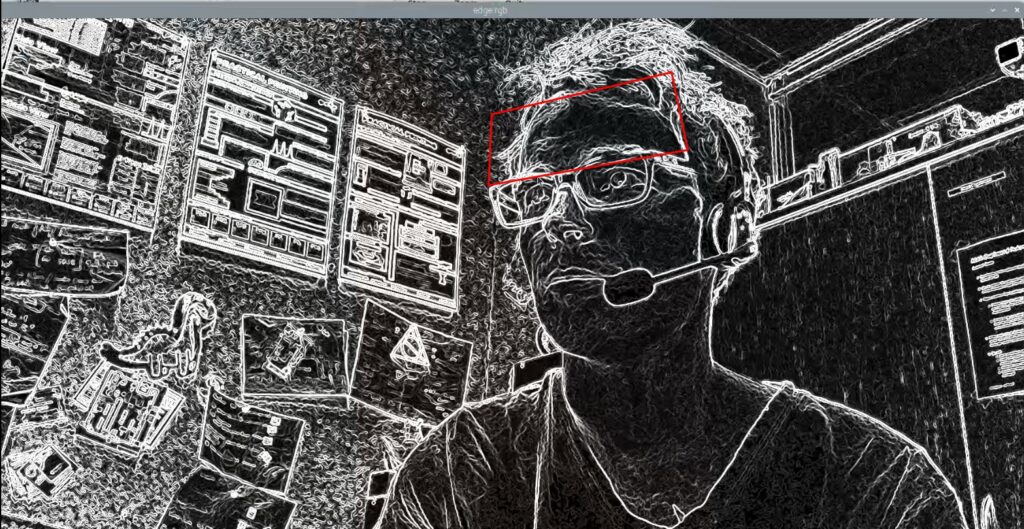

这个系统的工作方式如下。它首先聚焦并锁定一张人脸。然后它高度聚焦在那张人脸的前额。然后,它使用边缘检测图像处理软件(你可以在下图中看到)来过度夸大颜色/边缘变化。这就意味着它可以接收前额静脉的超细微搏动。然后,它使用机器学习系统来识别这些变化,这些变化与你的心跳速率相同,以确定你的BPM。太天才了!

这似乎是一个完美的婴儿监测系统,它不需要任何电线连接到婴儿身上,但可以提供所有积极的生命数据迹象,这是你想要的7*24全天候监控。

3D可打印支架

我已经为这个设备创建了两个3D打印支架。我用Ultimaker TPU 95在Ultimaker 2+ 3D打印机上打印了它们。必须要选柔性材料来打印,因为你需要这种柔韧性来将OAK-D-Lite安装到底座上而不造成损坏。

第一张是OAK-D-Lite的简单保护壳,设计者是Yang_GT,很棒的设计。第二个是我对最初设计的重新组合,它仍然是一个保护壳,但也是一个安装壳,使它可以很容易地连接到一个 Pimoroni 云台HAT。在之前的机器学习教程中,我用到了这个东西,还是挺合适的。这意味着我们现在可以始终将动作保持在画面的中间,请参见下图中这两个打印和装配的图片。

你可以从这里下载这些设计文件啊。

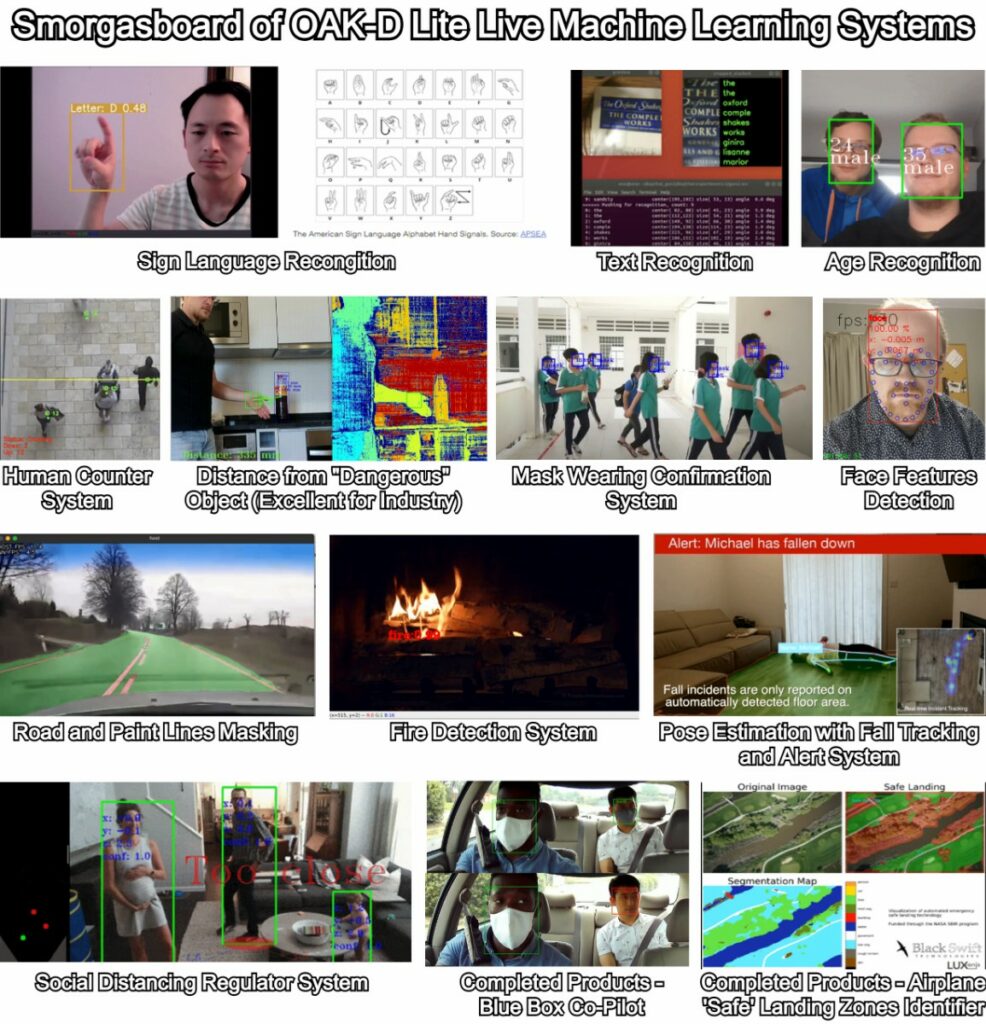

最后兼容的人工智能系统的大杂烩

只要你有一点好奇心,OAK-D-Lite就酷得离谱。下面是一个OAK-D-Lite兼容机器学习系统的大杂烩。在图像的最底部,甚至有一些产品在原型阶段就广泛使用了OAK-D-Lite。

以上所有内容(除了最后两个)都是Python脚本,可以在depthai-experiments找到。如果你在一些项目中卡住了,这个是非常好的资源。按照与本教程上述章节中演示的完全相同的方式打开并运行它们。上面也有一些测距的脚本,与接近机械臂或其他危险硬件相关的安全问题都可以用得上这些技术,你最终会得到一个不眠不休的监测器。

火灾和烟雾探测是一个可以解决的问题,但我认为他们需要更好的数据集。目前的模型仅仅基于颜色,因此一件红色/橙色的t恤可能也引起机器学习系统的注意。人类和动物很容易区分火,但它有许多不同的形式、形状和大小。。也许用边缘检测法比较火焰尖端和烟雾的系统会产生较少的误报,尽管如此,目前的模型仍然有其存在的意义。

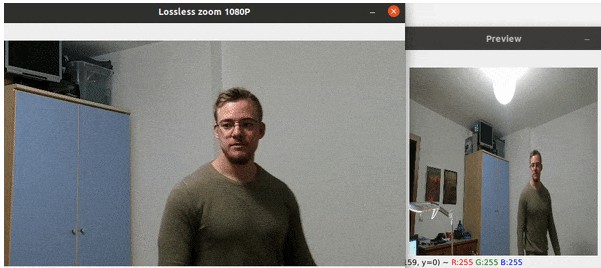

道路和油漆线掩蔽人工智能系统也是对自动驾驶汽车复杂性的一种非常酷的见解。无损变焦是OAK-D-Lite相机能做到的另一件非凡的事情,这也在depthai-experiments里。使用人脸识别技术,它利用边缘安装的摄像头瞄准人脸。找到一个人后,它就会锁定,然后提供树莓派系统的X和Y坐标,即人脸的中间位置。然后,它获取脸部的这些坐标,然后用4K相机放大/缩小。这会产生一个相机预览窗口,显示放大到目标脸部/身体的全高清视频,见下图。如果你在房间里走动,放大的部分会跟着你一起移动。

组织也已经把OAK-D-Lite变成了一个真正的消费级产品。Blue Box Co-Pilot是一款记录里程数、跟踪你的客户的摄像头,其功能与摄像头安全装置/仪表盘摄像头一样出色。这是了不起的。我相信它还可以检测驾驶员眼睛的疲劳,因此当驾驶员开始打盹时,它能发现(伴随着哈欠的记录)。Black Swift创建了OAK-D-Lite系统,为无人驾驶飞机提供紧急情况下可以安全着陆的地面位置。如果你真的对此感兴趣并想深入了解,有一个OAK-D板的开发版本叫做OAK-D-LITE-DEV。OAK-D Lite上的每一个硬件和软件都是开源的,除了英特尔Myriad X视觉处理单元(VPU)。OAK-D-LITE-DEV用一个开源的等价物代替了那一部分。

其他可以学习的地方。如果你想了解更多关于OpenCV的知识和树莓派机器学习系统,请点击YouTube上的LearnOpenCV频道,该频道由OpenCV的CEO Satya Mallick博士亲自主持。另外,这里是我创建的YouTube机器学习系统播放列表。