DepthAI ROS Release 3.0

大家好!

OAK现已推出了新版本的 DepthAI ROS软件包,专为 ROS 2 Kilted 构建并使用 DepthAI V3。

关键更新

- DepthAI 库 V3 集成

底层 DepthAI 库已更新至 V3,带来了许多新功能和BUG修复。有关详细信息,请参阅 depthai-core 库。

- RVC4 支持

这是第一个支持 OAK4 设备(OAK 4 D 和 OAK 4 S)的版本

- 重新命名的节点和参数

在depthai_ros_driver 的主要node现在修改为driver(之前是camera),用户应该升级yaml配置以体现这个改动。

camera.launch.py已经被弃用,取而代之的是driver.launch.py.

i_mx_id 已经被i_device_id所取代;

- 简化的神经网络创建

创建神经网络的过程在.depthai_examples和 depthai_ros_driver中都得到了简化。

i_nn_family 现在和i_nn_kind相对应(注意:未来这个参数可能会被重命名)

i_nn_model用于传递实际的神经网络模型。

新特性和功能

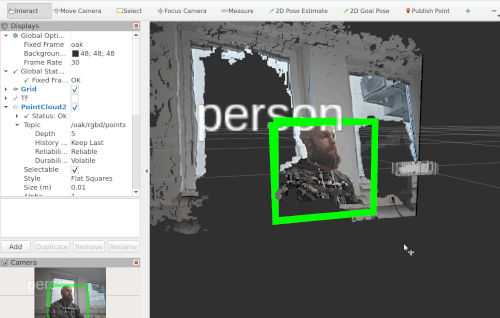

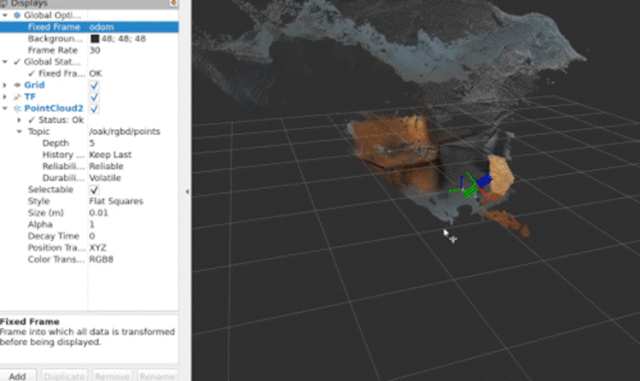

- 改进的 RGBD 和点云功能

添加了专用的RGBD 节点和点云转换器,用于生成性能显着提高的彩色点云。

RGBD 节点现在可用于发布 RGBD 点云,无需外部节点并提高性能。

- 用于增强流控制的摄像机节点

Mono/Color camera节点已被更通用的节点所取代。

这允许请求未失真的流,并指定准确的宽度和高度,而无需担心 ISP 缩放问题。

可通过设置和选择i_resize_mode,来请求未失真的流。

默认相机输出大小现在为 640×400,以获得更好的性能。

IMU现在以RDF帧发布:IMU 数据现在在 RDF 帧中一致地发布:Camerai_undistorted

- 默认情况下的TFPublisher

系统现在默认使用 TFPublisher 而不是 URDF 描述,以获得更准确的结果。

- 主机节点

现在可以将主机节点集成到管道中以提高性能。

- 独立的立体视觉FPS

该节点现在具有独立的FPS参数,与传感器FPS分开。

实验性的 – 新的 VIO 节点 – 基于开源库 (基础的),目前在主机上运行 RVC2 设备(RVC4 支持即将推出!),发布位置和里程计信息

我们还计划很快发布一个基于开源 RTABMap 库的VSLAM 节点!(它目前在 C++ 和 Python 实现的基本depthai-core 库上可用)Stereo

改进和优化

- 更新的 Socket/Frame 命名

Socket和Frame命名约定已更新,以准确反映不同的设备和配置。在rs_mode中,名称与Realsense一致,而特定设备(例如OAK-D-SR-PoE)使用特定于传感器的名称(例如 tof 而不是 rgb)。

- 简化的depthai_examples

depthai_examples 存储库已经过广泛修改,以删除已弃用的示例并简化现有代码。当前的示例包括:

- 管道创建的参数更改

与管道创建相关的参数已移至 PipelineGen PH,包括:

i_pipeline_type

i_nn_type

i_enable_rgbd

- Rviz 和 TF Frame更新

新的 Rviz 配置已被添加到一些示例中。base_frame 和parent_frame的TF Frames 已被分别调整为 NodeName 和 oak_parent_frame。有关完整的更新日志,您可以参考此链接。

如何获得:请根据我们官方文档查找说明操作

注意一些已知问题

- 分割神经网络、VIO 和 SLAM 目前仅适用于 RVC2 设备。

- 要使用 NNs,您需要互联网连接(用于模型下载)

- 对于 RVC4 设备,您只能将 COPY 用作 ImuSyncMethod。

- 尚不支持设置图像方向。

- 并非depthai_filters中的所有示例都可以正常工作。

- RGBD 节点尚无 GPU支持。

- 尚不支持使用外部话题作为驱动程序的输入